DiT架构大一统:一个框架集成图像、视频、音频和3D生成,可编辑、能试玩

作者:LR •更新时间:2025-08-01 15:00:24•阅读 0

基于 Diffusion Tran**ormer(DiT)又迎来一大力作「Flag-DiT」,这次要将图像、视频、音频和 3D「一网打尽」。

今年 2 月初,Sora 的发布让 AI 社区更加看到了基础扩散模型的潜力。连同以往出现的 Stable Diffusion、PixArt-α 和 PixArt-Σ,这些模型在生成真实图像和视频方面取得了显著的成功。这意味着开始了从经典 U-Net 架构到基于 Tran**ormer 的扩散主干架构的范式转变。

值得注意的是,通过这种改进的架构,Sora 和 Stable Diffusion 3 可以生成任意分辨率的样本,并表现出对 scaling 定律的严格遵守,即增加参数大小可以实现更好的结果。

不过,推出者们只对自家模型的设计选择提供有限的指导,并且缺乏详细的实现说明和公开的预训练检查点,限制了它们在社区使用和复刻方面的效用。并且,这些方法是针对特定任务(例如图像或视频生成任务)量身定制的,这阻碍了潜在的跨模态适应性。

为了弥补这些差距,上海 AI Lab、港中文和英伟达的研究者联合推出了 Lumina-T2X 系列模型,通过基于流(Flow-based)的大型扩散 Tran**ormers(Flag-DiT)打造,旨在将噪声转换为图像、视频、多视图 3D 对象和基于文本描述的音频。

其中,Lumina-T2X 系列中**的模型包括具有 70 亿参数的 Flag-DiT 和一个多模态大语言模型 SPHINX。SPHINX 是一个文本编码器,它具有 130 亿参数,能够处理 128K tokens。

- 论文地址:https://arxiv.org/pdf/2405.05945

- GitHub 地址:https://git**.com/Alpha-VLLM/Lumina-T2X

- 模型下载地址:https://huggingface.co/Alpha-VLLM/Lumina-T2I/tree/main

- 论文标题:Lumina-T2X: Tran**orming Text into Any Modality, Resolution, and Duration via Flow-based Large Diffusion Tran**ormers

具体来讲,基础的文本到图像模型 Lumina-T2I 利用流匹配框架,在精心整理的高分辨率真实图像文本对数据集上进行训练,只需要使用很少的计算资源就能取得真实感非常不错的结果。

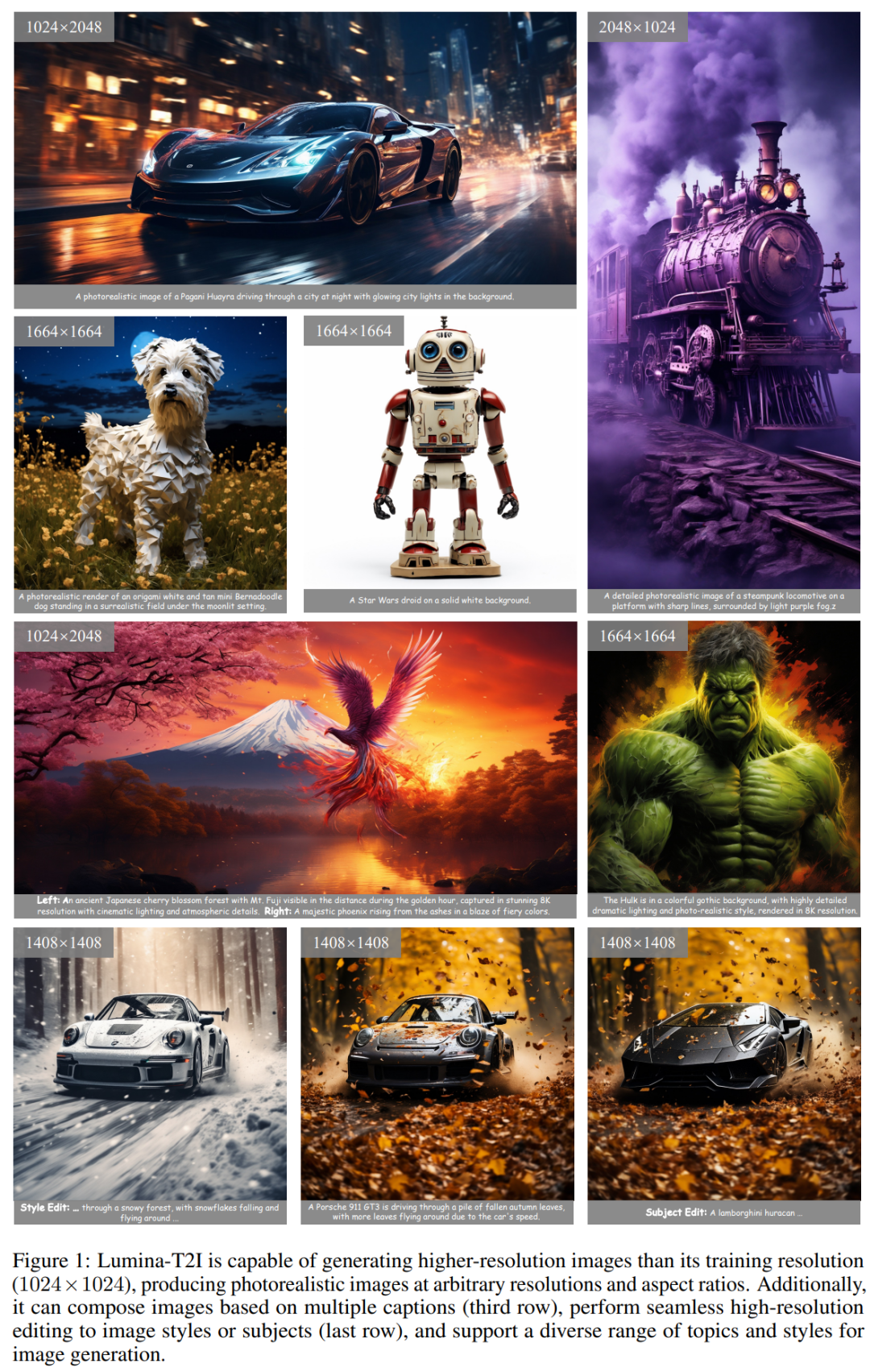

如图 1 所示,Lumina-T2I 可以生成任意分辨率和宽高比的高质量图像,并进一步实现**功能,包括分辨率外推、高分辨率编辑、构图生成和风格一致生成,所有这些都以免训练的方式无缝集成到框架中。

我们先来一睹实现效果如何。比如生成视频:

- 试用地址 1:http://106.14.2.150:10021/

- 试用地址 2:http://106.14.2.150:10022/

方法概览

Flag-DiT 架构

Flag-DiT 是 Lumina-T2X 框架的主干,它具有显著的稳定性、灵活性和可扩展性。

首先是 稳定性。Flag-DiT 建立在 DiT 之上,并结合 ViT-22B 和 LLaMa 来修改,以提高训练稳定性。具体来说,Flag-DiT 将所有 LayerNorm 替换为 RMSNorm,使得训练稳定性增强。

此外,Flag-DiT 在键查询点积注意力计算之前结合键查询归一化(KQ-Norm)。KQ-Norm 的引入旨在通过**注意力 logits 中极大值来防止损失发散。这种简单的修改可以防止混合精度训练下的发散损失,并有助于以更高的学习率进行优化。Flag-DiT 的详细计算流如图 2 所示。

因此,受最近展现出强大上下文外推能力的 LLM 的推动,他们用 RoPE 替换了 APE。RoPE 按照以下公式 1 和 2 以分层方式注入相对位置信息。

如图 3 所示,Lumina-T2X 在训练过程中主要由四个组件组成,接下来进行一一介绍。

使用多种文本编码器进行文本编码。对于文本条件生成,研究者使用预先训练的语言模型对文本提示进行编码。他们结合了各种大小不一的文本编码器,其中包括 CLIP、LLaMA、SPHINX 和 Phone 编码器,针对各种需求和模态进行量身定制,以优化文本调整。

输入和目标构建。Lumina-T2X 在流匹配中采用线性插值方案来构建输入和目标,具体如下公式 4 和 6 所示,简单灵活。并且,受到中间时间步对于扩散模型和流模型都至关重要的观察启发, 研究者在训练期间采用时间重采样策略从对数范数分布中采样时间步。

Lumina-T2X 系列模型包括了 Lumina-T2I、Lumina-T2V、LuminaT2MV 和 Lumina-T2Speech。对于每种模态,Lumina-T2X 都经过了针对不同场景优化的多配置独立训练,例如不同的文本编码器、VAE 潜在空间和参数大小。具体如图 17 所示。

除了基本的文本生成图像之外,文本到图像版本的 Lumina-T2I 还支持更复杂的视觉创作,并作为基础模型产生富有创造力的视觉效果。这包括分辨率外推、风格一致性生成、高分辨率图像编辑和构图生成。

与以往使用多种方法解决这些任务的策略不同,Lumina-T2I 可以通过 token 操作统一解决这些问题,如图 4 所示。

风格一致性生成。基于 Tran**ormer 的扩散模型架构使得 Lumina-T2I 自然地适合风格一致性生成等自注意力操作应用。

构图生成。研究者只将此操作应用于 10 个注意力交叉层,以确保文本信息被注入到不同的区域。同时保持自注意层不变,以确保**图像的连贯、和谐。

高分辨率编辑。除了高分辨率生成之外,Lumina-T2I 还可以执行图像编辑,尤其是对于高分辨率图像。

实验结果

在 ImageNet 上验证 Flag-DiT

研究者在有标签条件的 256×256 和 512×512 ImageNet 上进行实验,以验证 Flag-DiT 相对于 DiT 的优势。Large-DiT 是 Flag-DiT 的特化版本,采用了 DDPM 算法 ,以便与原始 DiT 进行公平比较。研究者**沿用了 DiT 的设置,但做了以下修改,包括混合精度训练、大学习率和架构修改套件(如 QK-Norm、RoPE 和 RMSNorm)。

研究者将其与 SOTA 方法的比较,如表 2 所示,Large-DiT-7B 在不使用无分类指导(CFG)的情况下,在 FID 和 IS 分数上明显超过了所有方法,将 FID 分数从 8.60 降至 6.09。这表明,增加扩散模型的参数可以显著提高样本质量,而无需依赖 CFG 等额外技巧。

Lumina-T2I 的结果

图 6 中展示了基本的文本到图像生成能力。扩散主干架构和文本编码器的大容量允许生成逼真的高分辨率图像,并能准确理解文本,只需使用 288 个 A100 GPU 天数。

研究者观察到,使用大批量的 Lumina-T2V 能够收敛,而小批量则难以收敛。如图 14 (a) 所示,将批量大小从 32 增加到 1024 会导致损失收敛。另一方面,与 ImageNet 实验中的观察相似,增加模型参数会加速视频生成的收敛速度。如图 14 (b) 所示,当参数大小从 600M 增加到 5B 时,我们能够在相同的训练迭代次数下一致观察到更低的损失。