TBcore提币流程 大数据新手入门的课程和书籍有什么推荐?

大数据新手入门的课程和书籍有什么推荐?

我是专业做数据分析的,每天都要对**的大数据进行分析。

个人觉得,数据分析最重要的是逻辑,而不是各种技术。所谓的逻辑就是你能够从繁琐复杂的各种标签中间整理出一个可以用于指导业务发展的模型。

然后在这个模型的基础上,通过大数据实时更新,形成某种预判机制,在别人还没有反应过来的同时,我们就已经抢得了商机,创造了利润。

说的比较抽象,你可以看一下我相关发布的文章,里面就有大数据的应用。

目前大数据的技术体系已经非常庞大了,初学者要根据自己的发展规划来制定学习规划,入门大数据的方式也要结合自己的知识基础。

对于要进入IT互联网行业从事大数据开发岗位的同学来说,入门大数据可以先从编程语言开始,接着学习大数据平台知识,然后结合大数据平台来完成场景开发实践。在编程语言的选择上,可以**考虑一下Java语言,相对于其他编程语言来说,目前Java岗位的人才需求量相对大一些。

对于要从事算法岗的同学来说,入门大数据也可以分成三个阶段,**个阶段是编程语言的学习,第二个阶段是学习算法基础,这个阶段需要学习一下统计学、机器学习相关知识,为后续奠定一个基础,第三个阶段是结合场景来开展算法实践,这个阶段也需要掌握大数据平台的相关知识。

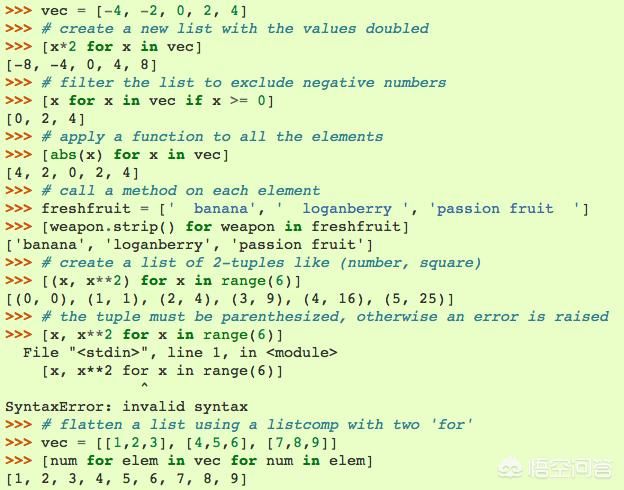

如果仅仅想通过学习大数据技术来提升自己的数据力,本身并没有从事大数据岗位的想法,那么入门大数据可以从学习Python语言开始,然后进一步学习基于Python语言来完成数据分析,这个过程同样要考虑到应用场景的问题,可以跟自己的专业方向相结合。

从整个大数据的技术体系结构来看,大数据技术涉及到数据采集、整理、存储、分析、呈现、应用和安全等领域,这些领域都可以采用单独学习的方式,比如既可以从数据采集开始学起,也可以从数据分析开始学起,但是不论从哪个领域开始学起,**要重视与场景相结合,不能脱离场景来学习大数据技术。

**,如果有学习大数据相关的问题,可以向我发起咨询。

大数据是目前最火的技术之一,《人类简史》的作者尤瓦尔·赫拉利**著作《未来简史》直言不讳说表达了未来是数据的天下,喊出了信数据得永生的口号。数据方面的人才是企业急需招聘和储备的**人才之一。

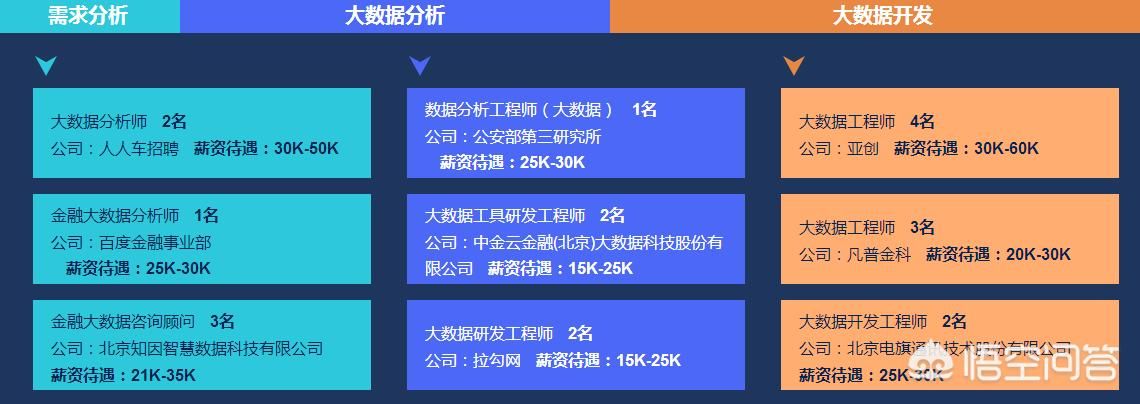

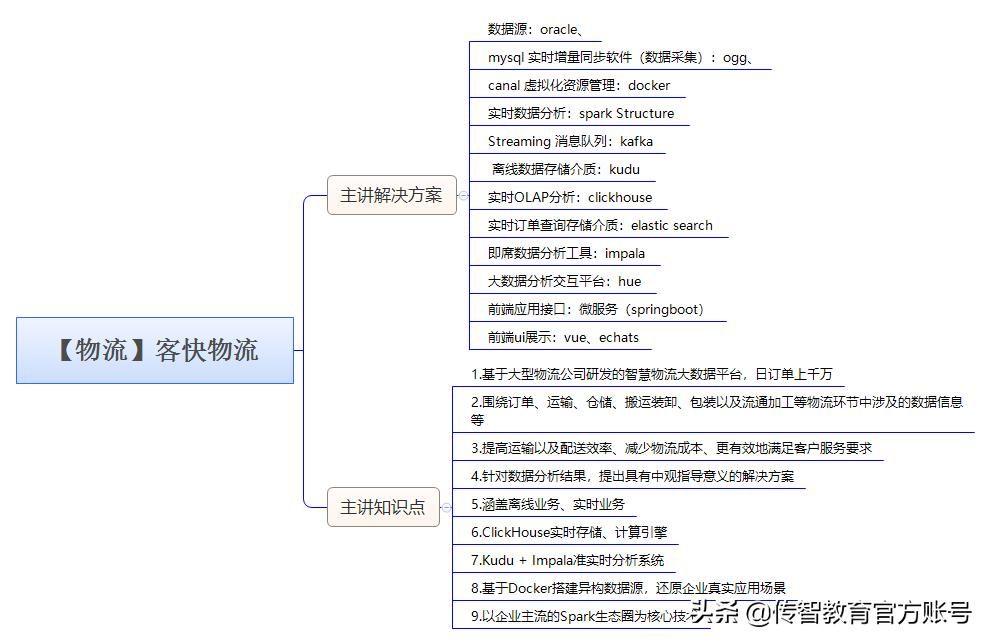

我们来看看这个图:

人人车、百度、拉勾这些公司都在招聘大数据分析师,并且工资都很高。关于大数据入门,可以给你一些阶段性的学习,希望能帮到你。

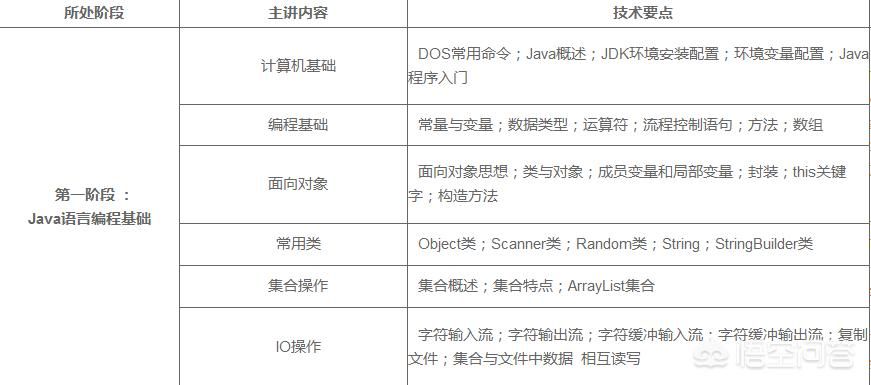

**阶段:

第二阶段:

第三阶段:

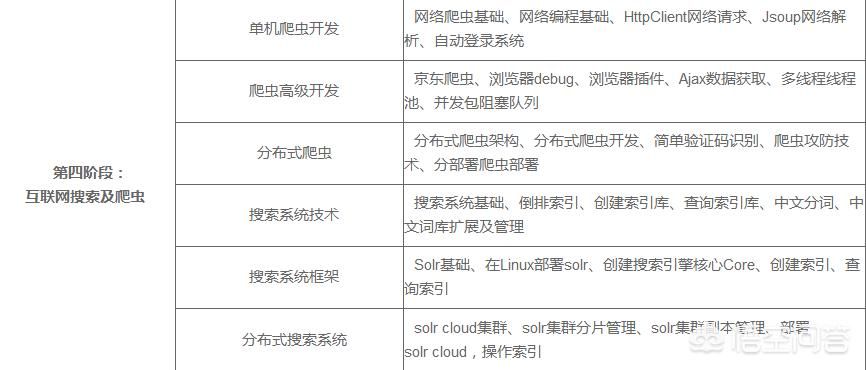

第四阶段:

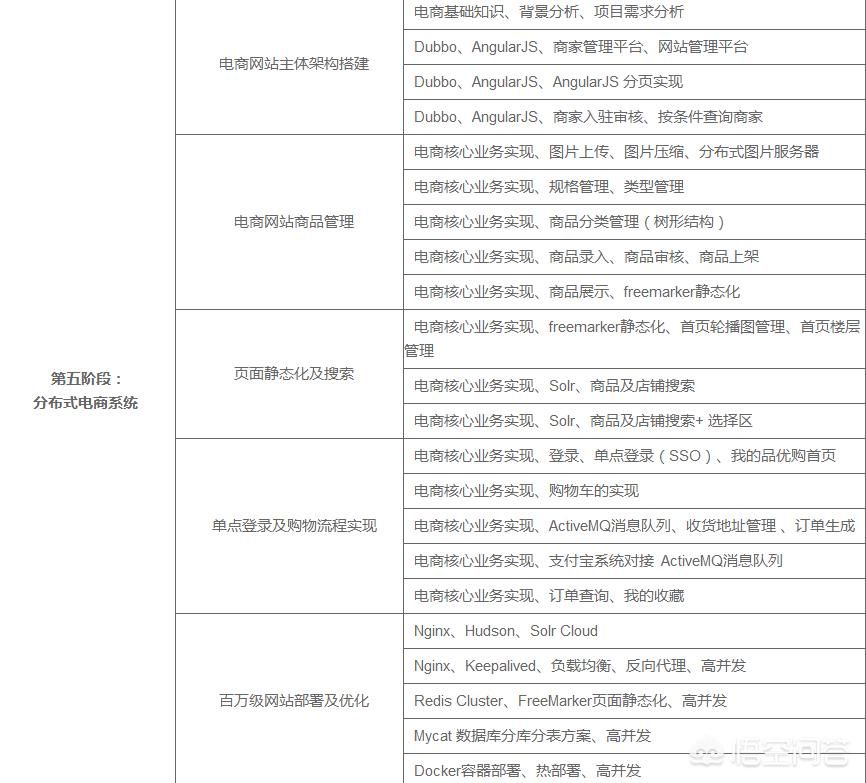

第五阶段:

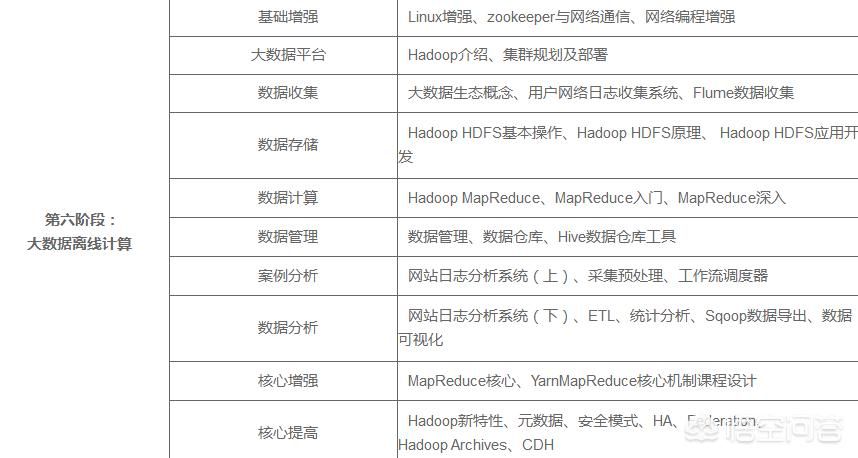

第六阶段:

第七阶段:

第八阶段:

第九阶段:

另外,我这里有部分大数据基础视频,可以给大家,有需要可以后台戳我。

这个问题其实还是挺难回答的,结合个人的工作经验,说一下我自己的看法。上班族和大学生非常适合线上学习呢,推荐北京尚学堂,他家线上平台是百战程序员,教学质量和师资力量都挺好的。在我看来**事情,**工作都是基于兴趣的前提下,当然兴趣和学习谁先谁后,这是一个循序渐进的过程。**:我们掌握了一些基本的知识,统计学是必不可少的,概率论等都是大数据的基础,大数据的本职是发现潜在的事物规律,因此统计学是一个再好不过的学科,通过样本来逼进总体,从而发现内在的规律,指导我们业务工作。第二:工具类,我们有基础的知识,但是我们还需要工具,工具是我们处理数据的利器。所以,我们需要掌握一些常用的工具,例如Excel、R、SQL等相关的语言。第三、兴趣,**保持兴趣,是一项工作取得成就的前提,能不能在大数据上深入的更深一些,需要我们拥有良好心态和积极主动的探索的精神。**,大数据是一个很大的概念,或者说涉及到的职业比较多,需要我们做好提前的判断,未来自己到底适应哪种职业,才能取得更好的成绩,如果掌握大数据技术,系统学习才是王道,那就来北京尚学堂吧,线上品牌是百战程序员。

新手入门大数据,首先要搞清楚自己的基础水平,学习本是一件严肃的事情,不能盲目,要有目标。

首先分为两类:一是有**的编程基础,想要学习大数据以达到技术的提升和深造;

二是零基础想要涉猎大数据行业。

作为零基础的你,建议你不要急于涉猎大数据技术,而是先深入学习一门编程语言(java、Python等等)。当然了如果感兴趣也可以看一下推荐的书籍,但主要任务还是要放在基础上。

作为有基础的你,可以先从以下大数据书籍入手:

大数据书籍

1、《为数据而生》

书中分别阐述在大数据1.0、大数据2.0和大数据3.0时代下,相对应的数据分析需要做到分析、外化、集成。

2、《智能时代》

这本书作者分七章从不同角度对大数据进行介绍,分别以技术和思维方式的改变为主线,从工业革命这个角度嵌入,顺理成章的延伸出大数据与智能化,但是没有将过多笔墨放在技术的深究上,而是选择从应用层面体现大数据的理念。大数据应用则会渗透到各行各业,这正是作者的用心之处。

3、《R语言预测实战》

R语言横跨了金融、生物、医学、互联网等多个领域,主要用于统计、建模及可视化。由于上手快、效率高,备受技术人员青睐。预测是大数据挖掘的主要作用之一,借助R语言来做大数据预测,可以兼具效率与价值于一身。

3、《数据之巅》

这本书中,从小数据时代到大数据的崛起,作者以宏大的历史观、文化观、大数据观,给我们描绘了一幅数据科学、智慧文化的全景图。

4、《Hadoop权威指南》

《Hadoop权威指南(中文版)》从Hadoop的缘起开始,由浅入深,结合理论和实践,全方位地介绍Hadoop这一高性能处理海量数据集的理想工具。

5、《Hive编程指南》

《Hive编程指南》是一本Apache Hive的编程指南,旨在介绍如何使用Hive的SQL方法HiveQL来汇总、查询和分析存储在Hadoop分布式文件系统上的大数据集合。

想要成为大数据工程师,需要以下的专业技术知识:

hadoop 、spark、storm开发、hive 数据库、Linux 操作系统、分布式存储、分布式计算框架大数据处理和分析技术等等

有需要更多学习资料和入门视频教程的,点赞关注联系我,免费分享!!!顶起来吧!

大数据怎么入门学习好?

大数据相比较于Java、Python等编程语言来说,确实是入门比较难的,不过如果想自学也没毛病,只要你了解大数据的学习路线图,跟着学习路线图来学习,不会走偏,那么,想学习还是很容易的哦!

分享给大家一套大数据的学习路线图

学习大数据,也需要一些编程语言要基础,之后还要学习Hadoop、spark等技术栈,在加上一些项目实战,就可以找工作喽!

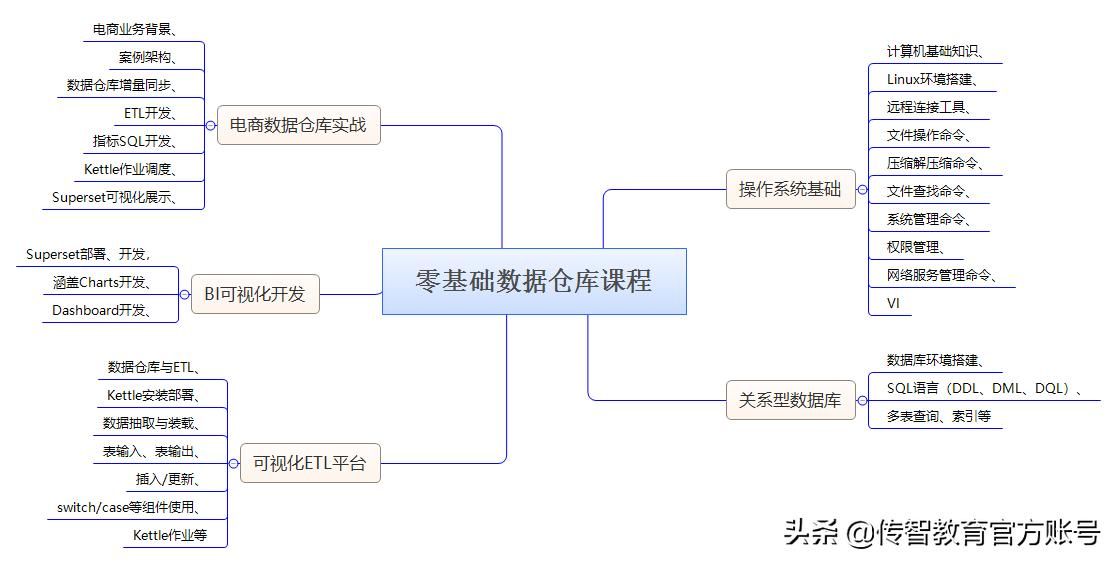

**阶段:零基础数据仓库管理

可掌握的核心能力

•掌握企业级ETL平台的kettle

•掌握BI的可视化平台Superset

•掌握Kettle ETL处理设计思想

•掌握大数据企业开发中最常见的linux的操作

•掌握一款主流数据库客户端工具DataGrip

•掌握企业MySQL的调优方案

•掌握大数据分析中数据全量及增量同步解决方案

•掌握生产环境中数据分析程序的部署解决方案

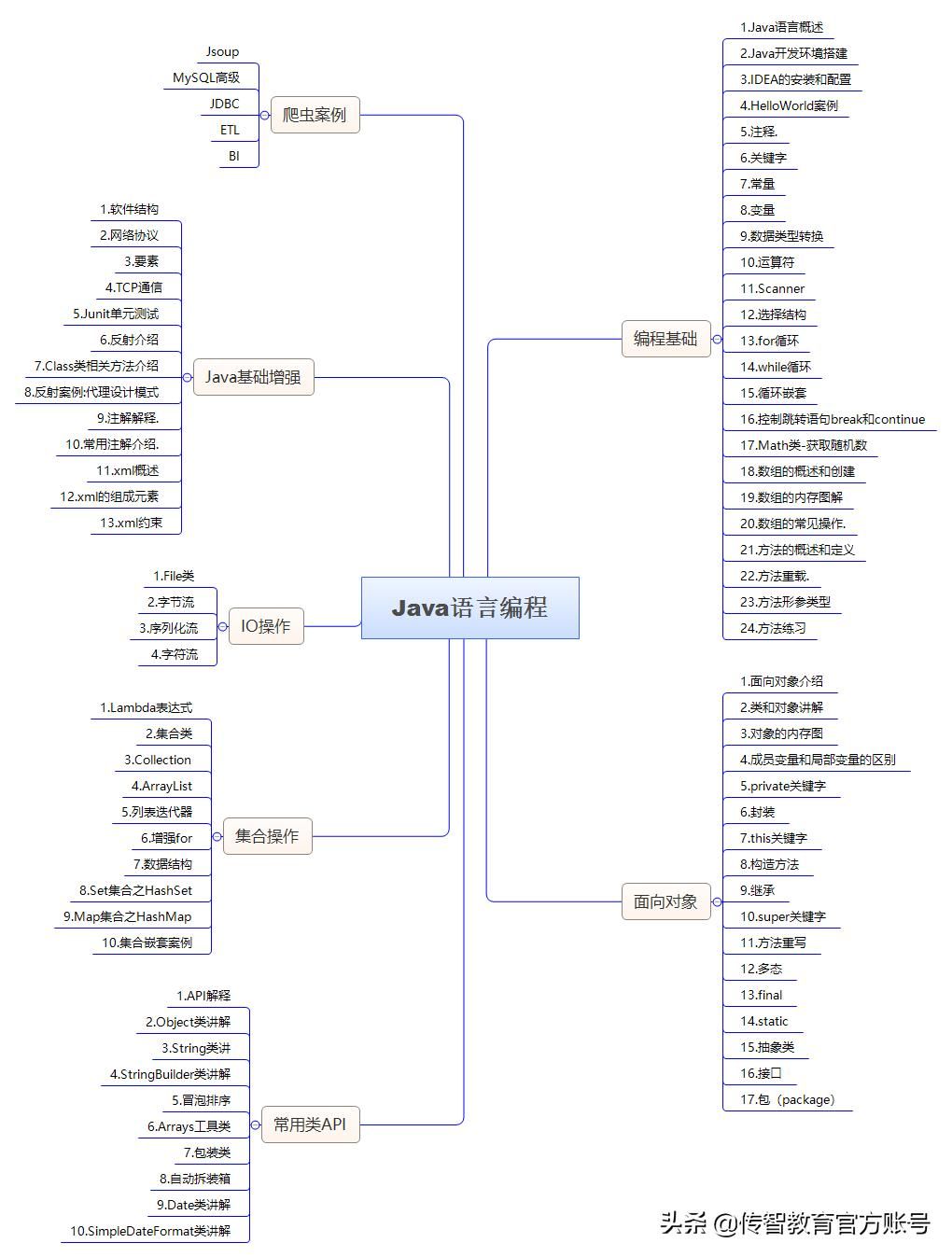

第二阶段:Java语言编程

可掌握的核心能力

•掌握Java程序基础数据类型

•掌握开发中常用类如集合、IO流、常用类等操作

•掌握Java异常处理机制

•掌握反射、网络编程、多线程开发

•掌握Jsoup的网络爬虫开发

•掌握JDBC操作

•掌握ETL数据处理和BI报表开发

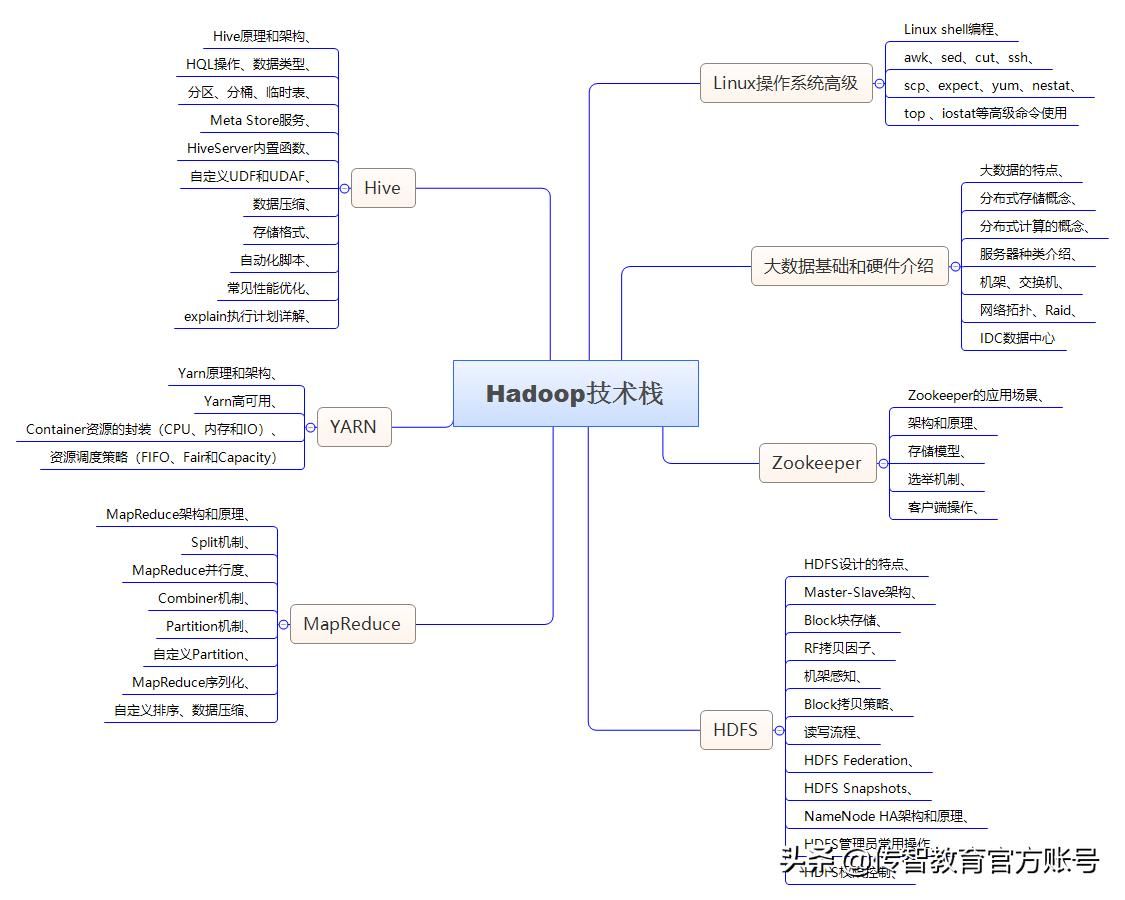

第三阶段:Hadoop技术栈

可掌握的核心能力

•掌握shell编程

•掌握ZooKeeper原理并应用

•掌握HDFS的使用和MapReduce编程

•理解MapReduce原理和调优

•掌握Yarn的原理和调优

•掌握Hive的使用和调优

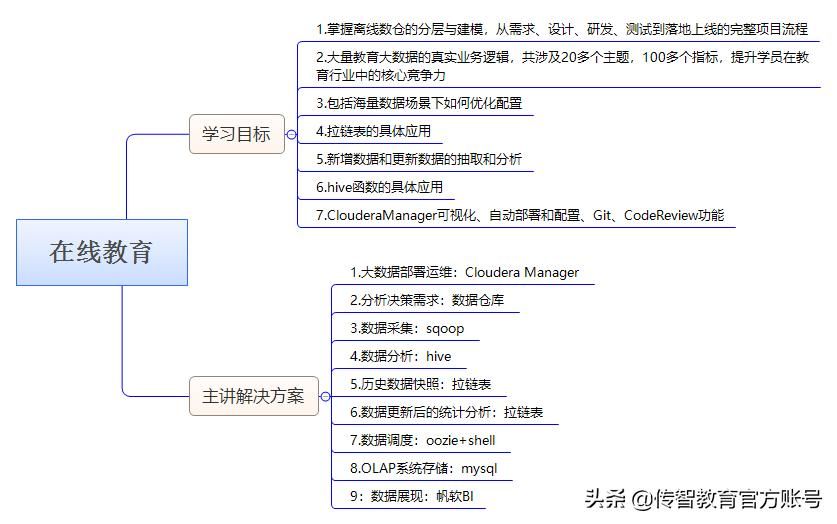

第四阶段:项目一(在线教育)

可掌握的核心能力

•掌握从需求、设计、研发、测试到落地上线的完整项目流程

•掌握大量教育行业的真实业务逻辑,涉及20多个主题,100多个指标

•掌握海量数据如何调优、使用拉链表、增量数据处理,以及Hive函数的具体应用等

•掌握基于CM的大数据环境部署和管理

•掌握数据仓库的核心概念和应用

•掌握常用离线大数据技术:Oozie、Sqoop、Hive等

•掌握FineReport可视化

第五阶段:数据微服务接口开发

可掌握的核心能力

•掌握SpringBoot整合SpringMVC开发

•掌握SpringBoot整合MyBatis开发

•掌握Eureka搭建

•掌握Feign的使用

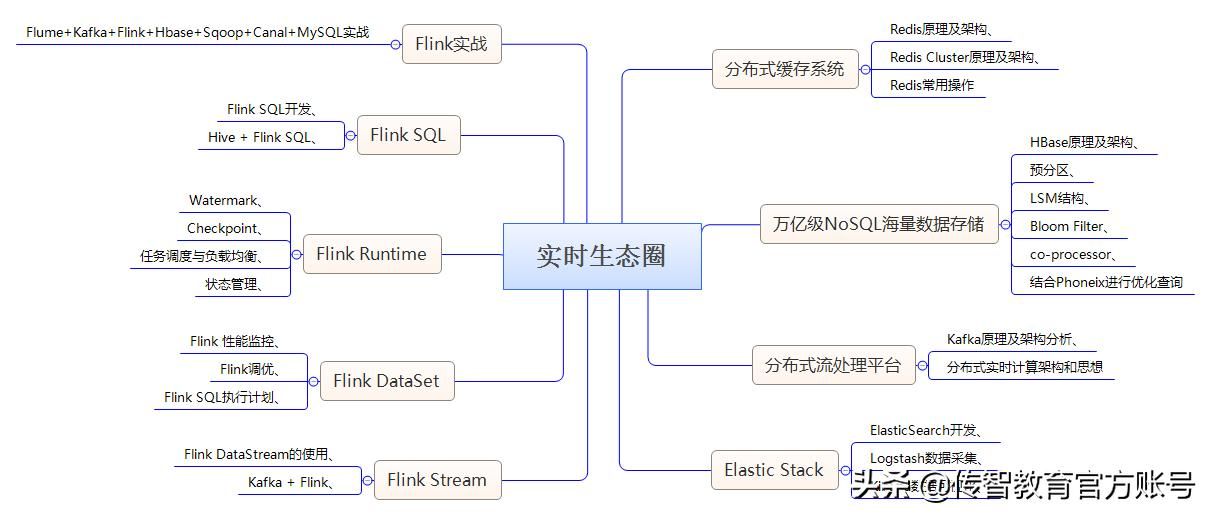

第六阶段:实时生态圈

可掌握的核心能力

•掌握Redis原理及架构

•掌握Redis命令操作、及数据结构

•掌握Hbase原理及架构

•掌握HBase命令操作、MapReduce编程

•掌握Phoneix二级索引优化查询

•掌握ELK开发掌握Kafka原理及架构

掌握KafkaStreams开发

掌握基于Flink进行实时和离线数据处理、分析

掌握基于Flink的多流并行处理技术

掌握千万级高速实时采集技术

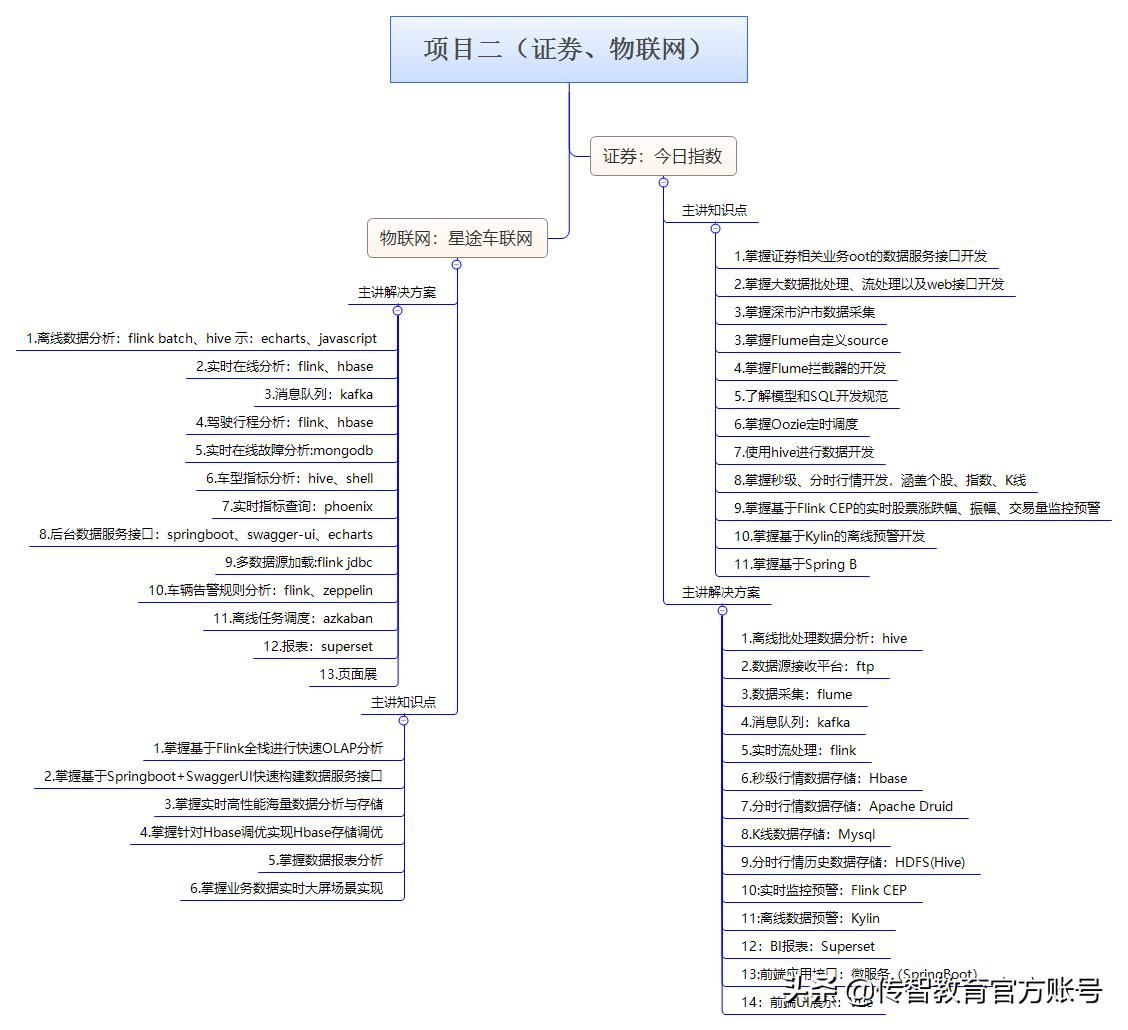

第七阶段:项目二(证券、物联网任选其一)

可掌握的核心能力

•掌握基于FTP、Flume Kafka的实时数据采集开发

•掌握TB级海量规模下Flink实时处理开发,保证实时计算高容错

•掌握三种不同时间维指标的存储、计算方案(Druid、MySQL、HBase),例如:毫秒级\秒级\分时等时间维

•掌握基于Kylin的即席快速OLAP开发

•掌握基于Flink CEP的实时预警监控开发

•掌握基于Spring Boot的数据服务接口开发

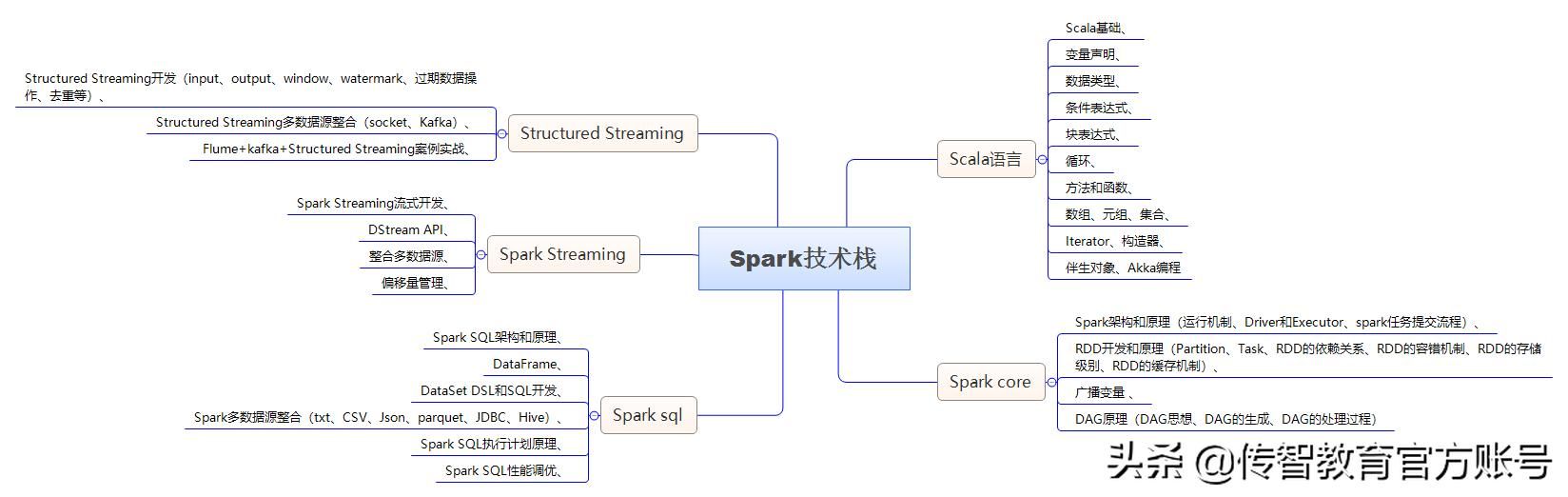

第八阶段:Spark技术栈

可掌握的核心能力

•掌握Scala语言基础、数据结构

•掌握Scala语言高阶语法特性

•掌握Spark的RDD、DAG、CheckPoint等设计思想

•掌握SparkSQL结构化数据处理,Spark On Hive整合

•掌握Spark Streaming整合Kafka完成实时数据处理

•掌握Spark Streaming偏移量管理及Checkpoint

•掌握Structured Streaming整合多数据源完成实时数据处理

第九阶段:项目三

可掌握的核心能力

•掌握Docker环境部署、管理操作

•掌握基于Oracle MySQL异构数据源数据处理技术

•掌握基于Oracle Golden Gate以及Canal的实时采集技术

•掌握Kudu Spark的快速离线数据处理、分析技术

•掌握Kudu Impala即席数据分析技术

•掌握基于ClickHouse高性能存储、计算引擎技术

•掌握基于ELK的全文检索技术

•掌握Kudu、Spark的调优能力

•掌握基于Spring Cloud的数据微服务接口开发技术

如果想要学习,有免费教程,可以私信我哦

大数据的入门学习有多条学习路线,可以根据自身的知识结构进行选择,并不是所有的学习路线都是从学Linux操作系统开始,然后是Java、Hadoop、Spark等,学习大数据也可以从数据分析开始。对于职场人来说,学习数据分析的工具如何使用,远比学习Hadoop更加实际。

大数据的核心是数据价值化,只要围绕这个核心所做的一系列数据价值化的操作都是大数据的分内之事,所以大数据学习的出发点比学习内容本身更重要,如果在学习大数据的初期就能建立数据价值化概念,那么对初学者来说是一个莫大的推动力,如何能快速建立数据价值化概念呢?答案就是从数据分析开始。

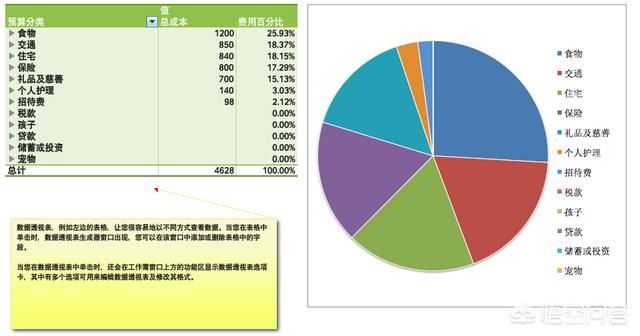

数据分析并没有那么复杂,即使是没有多少计算机基础的人也可以入门数据分析,并不是所有的数据分析都需要通过机器学习的方式来完成,有很多工具能够方便的完成数据分析,而这些工具本身并不是特别复杂,比如Excel。Excel是一个功能强大的数据分析工具,在没有大数据概念的年代,Excel就在做数据分析的事情,虽然在大数据时代数据分析更加多样化,但是通过Excel能让入门者快速发现“数据之美”,**可以通过Excel打开学习大数据的大门。

学习Excel可以从基本的函数开始学起,比如sum、count、Vlookup、sumif、countif、find等,这些函数的使用非常方便且功能强大,通过实验很快就能建立起数据分析的概念。Excel基本上能解决不少普通职场人的数据分析场景,几万条的数据分析使用Excel是没有压力的。

下一步学习就涉及到数据库的使用了,虽然目前大数据领域的非结构化数据占据着大部分的比例,但是目前大量的数据分析还是基于结构化数据进行的,所以学习一个数据库产品的使用就变得很有必要了,推荐学习一下Mysql数据库。掌握数据库之后,数据分析的数量就会有显著的提高,几百万条数据都是毫无压力的,相比于Excel来说,数据分析的量一下就得到了质的提高。

接着可以学习一下SPSS,SPSS是数据分析(统计)领域一个非常强大的工具,分析可以定制化,是一个比较常见的工具。在数据可视化方面可以学习一下Echarts,这是一个开源产品,功能也非常强大,同样可以进行定制化(程序化)。

学习数据分析一个比较麻烦的事情是数据从哪来?要想解决这个问题,就必须进行下个阶段的学习了,那就是Python编程,可以通过Python编写爬虫来爬取互联网上的海量数据,作为自己数据分析的基础。其实学习数据分析到中后期是绕不过编程的,掌握一门编程语言是非常有必要的,而Python就是数据分析最常见的编程语言之一。

数据分析涵盖的内容非常多,按照场景不同也有很多条分析路线,对于初学者来说可以采用递进式学习方式,这样会有更好的学习效果。

大数据是我的主要研究方向之一,目前我也在带大数据方向的研究生,我会陆续写一些关于大数据方面的文章,感兴趣的朋友可以关注我的头条号,相信**会有所收获。

如果有大数据方面的问题,也可以咨询我。

谢谢!